社交媒体上不能说的话

社交媒体上似乎存在一份禁忌词汇清单——至少,大家都这么认为。

或许你已经注意到,人们在社交媒体上会刻意避开某些词语。比如,他们会用“unlived”(未出生的)来代替“killed”(被杀死的)。枪会被说成“pew pews”(砰砰砰)。社交媒体用户们也坦言,这样做听起来很滑稽,但许多人认为他们别无选择。

这种语言通常被认为与“算法语言”有关 ,它是一种完全基于编码的语言,其核心思想是算法会隐藏使用禁忌词语或短语的内容,其目的要么是为了推进社交媒体公司的政治议程,要么是为了向广告商清理我们的信息流。

科技行业坚称这一切都是无稽之谈。YouTube 发言人 Boot Bullwinkle 对此解释得很清楚。“YouTube 没有禁用或限制词汇列表,”他告诉 BBC,“我们的政策体现了我们对语境重要性的理解,因为词语可以有不同的含义和意图。这种细致入微的方法的有效性,从 YouTube 上丰富多样的主题、声音和观点中可见一斑。” Meta 和 TikTok 也表达了同样的观点:我们从未这样做过,这纯属谣言,然而,事实远比这复杂。

历史上充斥着社交媒体公司悄悄操纵内容兴衰的例子,有时其做法甚至与其标榜的透明度和中立性背道而驰。即使并非直接针对个别词语,专家也指出,这些科技巨头确实会介入,以微妙的方式限制某些内容的传播。

问题在于你永远无法确定帖子失败的原因。是你说了什么惹恼了算法,还是你只是做了个糟糕的视频?这种不确定性助长了普遍的自我审查。一方面,这导致人们用滑稽的语言谈论严肃的话题。另一方面,一些只想博取眼球的用户则完全避开某些话题。

在社交媒体成为越来越多公众获取新闻和信息的主要来源的世界里,这意味着有些人可能永远无法听到某些观点。 亚历克斯·珀尔曼是一位内容创作者,在TikTok、Instagram和YouTube上拥有数百万粉丝,他们喜欢他的喜剧作品和辛辣的政治评论。珀尔曼说,算法审查在他的作品中无处不在。

“就拿TikTok来说,我很少提到‘YouTube’这个词。至少根据我的经验,如果我查看分析数据,发现我说‘去我的YouTube频道’之类的话,视频肯定会失败,”珀尔曼说道。他并非个例。珀尔曼和其他创作者的经验让他们认为,TikTok不希望用户把用户引流到竞争对手的平台,如果你提出这样的建议,TikTok会严厉批评你。(顺便一提,TikTok声称他们不会这样做。) 但珀尔曼说,有时,这些例子更令人不安。

珀尔曼制作了很多关于杰弗里·爱泼斯坦的视频。但去年八月,他注意到了一些奇怪的事情。

“当时正值爱泼斯坦事件闹得沸沸扬扬之际,”他说。“突然之间,我上传到TikTok的多个爱泼斯坦相关视频在一天之内就被下架了。”同样的视频在Instagram和YouTube上却安然无恙,但它们违反了TikTok的某条规则,而他却说不出具体是哪条。“他们不会直接指出哪句话违反了规定。你只能自己去琢磨那个黑框到底在告诉你什么。”珀尔曼说,他的申诉被驳回了,TikTok在他的账号上留下了“警告”,这会影响他通过该应用赚钱的能力。

“在那之后不久,我们就开始看到一些知名账号不再像以前那样直接谈论爱泼斯坦了,”他说。据珀尔曼说,其他创作者似乎也遇到了类似的问题,都在试图迎合算法。他并没有停止制作关于爱泼斯坦的视频,但珀尔曼尝试了另一种策略。“我开始用暗语谈论他,称他为‘岛人’,”他解释说,指的是爱泼斯坦臭名昭著的私人岛屿。“使用暗语的问题在于,很大一部分观众根本不知道你在说谁,”珀尔曼说。

我联系了TikTok的一位发言人。他们没有就珀尔曼与爱泼斯坦的纠纷发表评论,也拒绝公开置评。但他们提供了一些背景信息。简而言之,TikTok表示这是一种误解,并不反映其平台的运作方式。

2019年泄露的文件显示,TikTok指示审核人员屏蔽丑陋、贫穷、残疾或LGBTQ+用户的内容,因为这些内容会营造一种“不够精致和吸引人”的环境。

TikTok、Meta 和 YouTube 都表示,控制用户信息流的算法是复杂且相互关联的系统,利用数十亿个数据点来推送用户认为相关且满意的内容——而且这三家公司都会发布信息来解释这些系统的运作方式。例如,TikTok 表示,其推荐内容基于对每个用户与视频互动可能性的预测。这些公司表示,他们确实会删除或屏蔽帖子,但仅限于违反明确规定的社区准则的情况,这些准则旨在平衡安全与言论自由。TikTok、Meta 和 YouTube 都表示,他们会始终通知用户这些决定,并且都会定期发布透明度报告,详细说明其审核决定。

但据英国广播公司、倡导团体、研究人员和其他新闻媒体的调查显示,社交媒体平台实际上屡次干预哪些声音会被放大或掩盖,这与其关于开放和公平竞争的言论相矛盾。

英国广播公司(BBC)和人权观察组织(Human Rights Watch)的独立调查发现,在10月7日哈马斯袭击以色列后的几周内,Facebook和Instagram系统性地限制了巴勒斯坦用户以及支持巴勒斯坦人权的内容。Meta公司的一位发言人告诉BBC,该公司会犯“错误”,但任何暗示其故意压制特定声音的说法都是“绝对错误的”。

2023年,TikTok承认其平台有一个秘密的“爆款”按钮,用于让精心挑选的视频迅速走红。据报道,该工具曾被用于拓展商业合作关系,有时也被员工滥用。TikTok没有回答我关于这种做法是否仍在继续的问题。

“既然有加热按钮,肯定也有制冷按钮,”珀尔曼说。“道理很简单。”

YouTube也曾面临类似的争议。例如,2019年,一群LGBTQ+创作者起诉YouTube,声称该公司取消了包含“gay”或“trans”等词语的视频的盈利资格。该诉讼被驳回,YouTube表示,其从未有过禁止或取消LGBTQ+相关内容盈利资格的政策。

不存在的音乐节

社交媒体公司确实会进行人为干预,而且在某些情况下,他们也乐于公开承认这一点。例如,TikTok 就设有多个网页详细解释其推荐系统。该公司表示,他们致力于“保持内容中立”,换句话说,推荐系统旨在包容所有社群,并对推荐内容保持公正。然而,并非所有视频都具有同等价值。该公司还表示,用户的信息流设计也遵循“尊重当地语境和文化规范”以及“为广大用户,尤其是青少年,提供安全的体验”的原则。 加州大学洛杉矶分校(UCLA)批判性互联网研究中心主任兼教授莎拉·T·罗伯茨表示,问题在于社交媒体的政策过于强硬且难以察觉。罗伯茨说,人们很少知道界限在哪里,也不知道平台何时会悄悄地将一些帖子推送出去,而将另一些帖子隐藏起来。

“这是一种对规则的工具化利用,这些规则乍一看,甚至深入探究之后,对普通人来说都毫无意义,”她说。“在这种晦涩难懂的背景下,人们提出了各种各样的民间理论。”

所有这些怪异的行为和反应,只有在一个本身就毫无逻辑的世界里才说得通,而这个世界就是社交媒体——莎拉·T·罗伯茨

罗伯茨认为,建立规避各种规则(无论规则是真实存在的还是人们想象出来的)的机制,最终会成为文化的一部分,并可能将事物引向歧途。

2025年8月,成千上万的社交媒体用户涌入网络,热议洛杉矶即将举办的一场激动人心的新音乐节。人们津津乐道于萨布丽娜·卡彭特的演出,津津乐道于灯光秀的盛况。然而,根本没有音乐节,卡彭特也没有登台表演。这一切都是谎言,而你本该知道这一点。

Previous Post 建议科技公司对人工智能生成的内容进行标注和“水印”处理

Next Post 两名比利时网红和卢浮宫保安“斗智斗勇”

Related Information

- 纽约法拉盛新年游行万人同乐 霍楚中文拜年 12/02/2024

- 纽约大都会艺术博物馆龙年新春节庆活动吸引喜爱中华文化的数千家庭参与 08/02/2024

- 2024年柏林电影节因成本原因将缩减规模 15/07/2023

- 世外桃源:新西兰皇后镇 18/07/2023

- 香港瑰丽酒店荣获世界 50 佳酒店榜单第一名 17/11/2025

- 毒枭“矮子”古兹曼之子在美国贩毒案中认罪 02/12/2025

- 社交媒体上不能说的话 01/12/2025

- 美国国家航空航天局局长祝贺嫦娥六号任务取得成功 中方回应 07/06/2024

- 美国会众议院通过法案:制裁国际刑事法院检察官 06/06/2024

- 2024年巴黎奥运会开幕式震撼上演,塞纳河化身超级剧院迎八方来客 27/07/2024

- 美允许英伟达对华出口人工智能晶片 10/12/2025

- 上海罗丹艺术中心启幕 中法再添重要艺术纽带 28/09/2024

Latest News

- 1

- 勒布伦兄弟促法国乒乓普及 15/12/2025

- 2

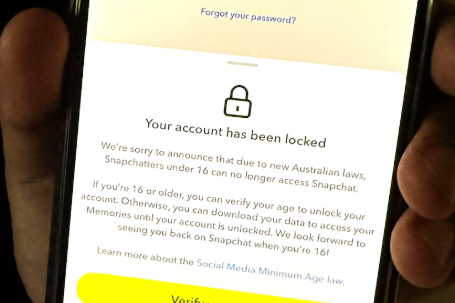

- 澳大利亚社交媒体禁令生效,青少年账号被锁定 10/12/2025

- 3

- 美允许英伟达对华出口人工智能晶片 10/12/2025

- 4

- 美允许英伟达对华出口人工智能晶片 10/12/2025

- 5

- 王毅:台湾地位已被“七重锁定” 10/12/2025

- 6

- 微软斥资175亿美元在印度设AI设施 创亚洲最大投资 10/12/2025

- 7

- 特朗普批评欧洲国家“衰落”和领导人“软弱无能”。 10/12/2025

- 8

- 法农业部长:中国将认证70款勃艮第IGP葡萄酒,对法国苜蓿亦有兴趣 08/12/2025

- 9

- 法农业部长:中国将认证70款勃艮第IGP葡萄酒,对法国苜蓿亦有兴趣 08/12/2025

- 10

- 2026法国小姐选美:塔希提小姐摘得桂冠 08/12/2025

- 11

- 卢浮宫埃及藏书泡水了 08/12/2025

- 12

- 尽管对美出口大幅下降,中国贸易顺差在短短11个月内就达到了1万亿美元。 08/12/2025